چگونه یک فایل robots.txt ایجاد کنیم؟

- مجموعه: متفرقه اينترنت و كامپيوتر

فایل robots.txt:سلاح مخفی شما برای کنترل خزندههای موتورهای جستجو

فایل robots.txt چیست؟

Robots.txt یک فایل متنی است که مدیران وبسایت برای آموزش به روباتهای وب (معمولاً روباتهای موتورهای جستجو) ایجاد میکنند که چگونه در صفحات وبسایت خود بخزند. فایل robots.txt بخشی از پروتکل حذف روبات ها (REP) است، گروهی از استانداردهای وب که نحوه خزیدن روبات ها در وب، دسترسی و فهرست بندی محتوا و ارائه آن محتوا به کاربران را تنظیم می کند. REP همچنین شامل دستورالعملهایی مانند رباتهای متا و همچنین دستورالعملهای صفحه، زیردایرکتوری یا سراسر سایت برای نحوه برخورد موتورهای جستجو با لینکها (مانند «دنبال کردن» یا «nofollow») است.

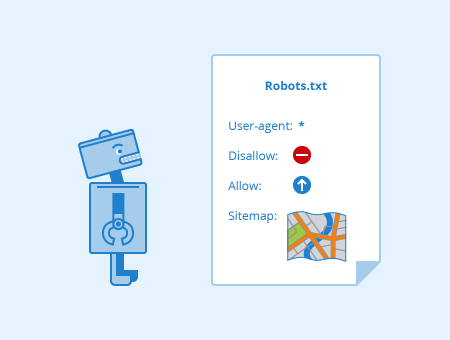

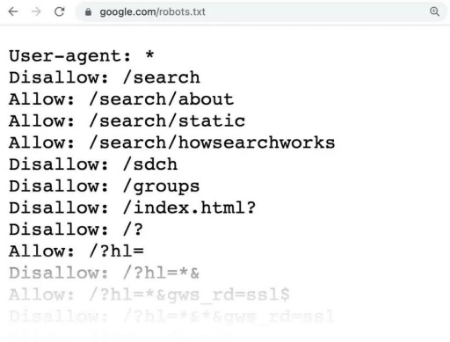

در عمل، فایلهای robots.txt نشان میدهند که آیا برخی از عوامل کاربر (نرمافزار خزنده وب) میتوانند یا نمیتوانند بخشهایی از یک وبسایت را بخزند. فایل robots.txt از دو دستور اصلی استفاده میکند:

allow: این دستور به خزندهها اجازه میدهد تا یک مسیر خاص را فهرستبندی کنند.

disallow: این دستور به خزندهها اجازه نمیدهد تا یک مسیر خاص را فهرستبندی کنند.

قالب اصلی:

User-agent: [user-agent name]Disallow: [URL string not to be crawled]

این دو خط با هم به عنوان یک فایل robots.txt کامل در نظر گرفته میشوند، اگرچه یک فایل روبات میتواند شامل چندین خط از عوامل و دستورالعملهای کاربر باشد (یعنی غیرمجاز، مجاز، تاخیر در خزیدن و غیره).

در فایل robots.txt، هر مجموعه از دستورالعملهای عامل کاربر بهعنوان مجموعهای مجزا ظاهر میشود که با یک شکست خط از هم جدا شدهاند:

در یک فایل robots.txt با چندین دستورالعمل کاربر-عامل، هر قانون غیر مجاز یا مجاز فقط برای عامل های کاربر مشخص شده در آن مجموعه جدا شده از خط خاص اعمال می شود. اگر فایل حاوی قاعدهای باشد که برای بیش از یک کاربر-عامل اعمال میشود، خزنده فقط به خاصترین گروه دستورالعملها توجه میکند (و دستورالعملها را دنبال میکند).

در اینجا یک مثال است:

Robots.txt.png?mtime=20170427090303#asset:5201:large

Msnbot، discobot و Slurp همگی به طور خاص فراخوانی شدهاند، بنابراین این عوامل کاربر فقط به دستورالعملهای بخشهای فایل robots.txt توجه میکنند. سایر عوامل کاربر دستورالعمل های موجود در گروه *:user-agent را دنبال خواهند کرد.

robots.txt چگونه کار می کند؟

موتورهای جستجو دو کار اصلی دارند:

1. خزیدن در وب برای کشف محتوا؛

2. ایندکس کردن آن محتوا به طوری که بتوان آن را برای جستجوگرانی که به دنبال اطلاعات هستند ارائه کرد.

برای خزیدن در سایتها، موتورهای جستجو لینک هایی را دنبال میکنند تا از یک سایت به سایت دیگر برسند، در نهایت، در میان میلیاردها لینک و وبسایت خزیده میشوند. این رفتار خزیدن گاهی اوقات به عنوان "عنکبوت" شناخته می شود.

خزنده جستجو پس از رسیدن به یک وب سایت اما قبل از خزیدن در آن، به دنبال فایل robots.txt می گردد. اگر یکی را پیدا کرد، خزنده ابتدا آن فایل را قبل از ادامه صفحه می خواند. از آنجایی که فایل robots.txt حاوی اطلاعاتی در مورد نحوه خزیدن موتور جستجو است، اطلاعاتی که در آنجا یافت میشود، اقدامات بیشتر خزنده را در این سایت خاص راهنمایی میکند. اگر فایل robots.txt حاوی هیچ دستورالعملی نباشد که فعالیت یک کاربر-عامل را ممنوع کند (یا اگر سایت فایل robots.txt نداشته باشد)، به خزیدن اطلاعات دیگر در سایت ادامه خواهد داد.

robots.txt در یک سایت کجا می رود؟

هر زمان که به سایتی میآیند، موتورهای جستجو و سایر روباتهای خزنده وب (مانند خزنده فیسبوک ، Facebot) میدانند که به دنبال یک فایل robots.txt بگردند. اما، آنها فقط آن فایل را در یک مکان خاص جستجو می کنند: دایرکتوری اصلی (معمولاً دامنه اصلی یا صفحه اصلی شما). اگر یک عامل کاربر از www.example.com/robots.txt بازدید کند و فایل روباتی را در آنجا پیدا نکند ، فرض می کند که سایت فایلی ندارد و به خزیدن همه چیز در صفحه (و شاید حتی در کل سایت) ادامه می دهد. حتی اگر صفحه robots.txt مثلاً در example.com/index/robots.txt یا www.example.com/homepage/robots.txt وجود داشته باشد ، توسط عوامل کاربر کشف نمی شود و در نتیجه سایت مورد بررسی قرار می گیرد. انگار اصلا فایل روباتی نداشت.

برای اطمینان از یافتن فایل robots.txt، همیشه آن را در فهرست اصلی یا دامنه اصلی خود قرار دهید.

چرا به robots.txt نیاز دارید؟

فایل های Robots.txt دسترسی خزنده به مناطق خاصی از سایت شما را کنترل می کنند. در حالی که اگر شما به طور تصادفی Googlebot را از خزیدن در کل سایت خود (!!) منع کنید، می تواند بسیار خطرناک باشد، اما در مواردی وجود دارد که فایل robots.txt می تواند بسیار مفید باشد.

برخی از موارد استفاده رایج عبارتند از:

• جلوگیری از ظاهر شدن محتوای تکراری در SERP (توجه داشته باشید که متا روبات ها اغلب انتخاب بهتری برای این کار هستند)

• خصوصی نگه داشتن بخش های کامل یک وب سایت (به عنوان مثال، سایت مرحله بندی تیم مهندسی شما)

• جلوگیری از نمایش صفحات نتایج جستجوی داخلی در SERP عمومی

• تعیین مکان نقشه های سایت

• جلوگیری از ایندکس کردن فایل های خاص در وب سایت شما (تصاویر، PDF و غیره) توسط موتورهای جستجو.

• تعیین تأخیر خزیدن به منظور جلوگیری از بارگیری بیش از حد سرورهای شما هنگام بارگیری همزمان چند قطعه محتوا توسط خزنده ها

• اگر هیچ ناحیه ای در سایت شما وجود ندارد که بخواهید دسترسی کاربر-عامل به آن را کنترل کنید، ممکن است اصلاً به فایل robots.txt نیاز نداشته باشید.

نحوه بررسی وجود فایل robots.txt

مطمئن نیستید که فایل robots.txt دارید؟ به سادگی نام دامنه خود را تایپ کنید، سپس /robots.txt را به انتهای URL اضافه کنید. به عنوان مثال، فایل روبات های Moz در moz.com/robots.txt قرار دارد.

اگر صفحه txt. نمایش داده نشد، در حال حاضر صفحه robots.txt (زنده) ندارید.

چگونه یک فایل robots.txt ایجاد کنیم؟

اگر متوجه شدید که فایل robots.txt ندارید یا می خواهید فایل خود را تغییر دهید،این یک فرآیند ساده است.برای ایجاد یک فایل robots.txt، به یک ویرایشگر متن مانند Notepad یا TextEdit نیاز دارید. سپس، مراحل زیر را دنبال کنید:

1. یک فایل جدید ایجاد کنید و آن را "robots.txt" نامگذاری کنید.

2. فایل را در دایرکتوری اصلی وبسایت خود قرار دهید.

3. دستورات مورد نظر خود را به فایل اضافه کنید.

بهترین شیوه های سئو

• اطمینان حاصل کنید که هیچ محتوا یا بخشی از وب سایت خود را که می خواهید خزیده شود مسدود نمی کنید.

• اگر صفحهای را با robots.txt مسدود کنید، موتورهای جستجو نمیتوانند از طریق آن صفحه به سایر صفحات وبسایت شما دسترسی پیدا کنند. این بدان معناست که:

1)صفحات مسدود شده ممکن است در نتایج جستجو ظاهر نشوند.

2)ارزش گذاری لینک (link equity) از صفحات مسدود شده به سایر صفحات منتقل نمیشود.

اگر میخواهید موتورهای جستجو به صفحهای دسترسی نداشته باشند، اما همچنان ارزش گذاری لینک از آن صفحه به سایر صفحات منتقل شود، باید از روشی غیر از robots.txt برای مسدود کردن آن صفحه استفاده کنید.

• از robots.txt برای جلوگیری از نمایش داده های حساس (مانند اطلاعات خصوصی کاربر) در نتایج SERP استفاده نکنید. از آنجایی که صفحات دیگر ممکن است مستقیماً به صفحه حاوی اطلاعات خصوصی پیوند بخورند (در نتیجه دستورالعملهای robots.txt در دامنه اصلی یا صفحه اصلی شما را دور میزنند)، ممکن است همچنان ایندکس شود. اگر میخواهید صفحه خود را از نتایج جستجو مسدود کنید، از روش دیگری مانند محافظت با رمز عبور یا دستورالعمل متا noindex استفاده کنید.

• برخی از موتورهای جستجو دارای چندین عامل کاربر هستند. به عنوان مثال، Google از Googlebot برای جستجوی ارگانیک و Googlebot-Image برای جستجوی تصویر استفاده می کند. اکثر عوامل کاربر از یک موتور جستجو از قوانین یکسانی پیروی می کنند، بنابراین نیازی به تعیین دستورالعمل برای هر یک از خزنده های متعدد موتور جستجو وجود ندارد، اما داشتن توانایی انجام این کار به شما این امکان را می دهد که نحوه خزیدن محتوای سایت خود را دقیق تنظیم کنید.

• یک موتور جستجو محتویات robots.txt را در حافظه پنهان نگه می دارد، اما معمولاً حداقل یک بار در روز مطالب ذخیره شده را به روز می کند. اگر فایل را تغییر میدهید و میخواهید آن را سریعتر از آنچه اتفاق میافتد بهروزرسانی کنید، میتوانید نشانی اینترنتی robots.txt خود را به Google ارسال کنید.

تفاوت Robots.txt با رباتهای متا و x-robots

رباتهای وب (crawlers) ابزارهایی هستند که توسط موتورهای جستجو برای پیمایش و فهرستبندی وبسایتها استفاده میشوند. سه نوع دستورالعمل ربات وجود دارد که رباتهای وب را کنترل میکنند:

• robots.txt: یک فایل متنی است که در دایرکتوری اصلی وبسایت قرار دارد و به رباتها میگوید که کدام صفحات را خزیده و کدام صفحات را نخزند.

• رباتهای متا: دستورالعملهایی هستند که در تگهای متا در صفحه وب قرار میگیرند و به رباتها میگویند که چگونه آن صفحه را خزیده و فهرستبندی کنند.

• رباتهای x-robots: دستورالعملهایی هستند که در هدر HTTP صفحه وب قرار میگیرند و به رباتها میگویند که چگونه آن صفحه را خزیده و فهرستبندی کنند.

تفاوت بین این سه نوع دستورالعمل ربات در این است که:

• robots.txt یک فایل متنی است، در حالی که رباتهای متا و x دستورات متا هستند.

• robots.txt رفتار خزیدن در سراسر سایت یا دایرکتوری را دیکته میکند، در حالی که رباتهای متا و x میتوانند رفتار فهرستبندی را در سطح صفحه (یا عنصر صفحه) فردی دیکته کنند.

سوالات متداول درباره robots.txt

1. robots.txt چیست؟

robots.txt یک فایل متنی است که در دایرکتوری اصلی وبسایت قرار دارد و به رباتهای وب (crawlers) میگوید که کدام صفحات را خزیده و کدام صفحات را نخزیدند.

2. دو دستور اصلی در فایل robots.txt چیست؟

دو دستور اصلی در فایل robots.txt عبارتند از:

allow: این دستور به خزندهها اجازه میدهد تا یک مسیر خاص را بخزند.

disallow: این دستور به خزندهها اجازه نمیدهد تا یک مسیر خاص را بخزند.

3. چگونه یک فایل robots.txt ایجاد کنم؟

برای ایجاد یک فایل robots.txt، به یک ویرایشگر متن مانند Notepad یا TextEdit نیاز دارید. سپس، مراحل زیر را دنبال کنید:

- یک فایل جدید ایجاد کنید و آن را "robots.txt" نامگذاری کنید.

- فایل را در دایرکتوری اصلی وبسایت خود قرار دهید.

- دستورات مورد نظر خود را به فایل اضافه کنید.

4. چرا باید از robots.txt استفاده کنم؟

استفاده از robots.txt میتواند به دلایل مختلفی مفید باشد، از جمله:

- جلوگیری از فهرستبندی محتوای حساس یا خصوصی

- بهبود عملکرد وبسایت

- کنترل خزندههای مخرب

5. آیا robots.txt همیشه کار میکند؟

خیر، robots.txt همیشه کار نمیکند. موتورهای جستجو ممکن است تصمیم بگیرند که از دستورات robots.txt پیروی نکنند.

6. آیا دستورالعملهای robots.txt در همه موتورهای جستجو یکسان است؟

خیر، دستورالعملهای robots.txt در همه موتورهای جستجو یکسان نیست. هر موتور جستجو ممکن است دستورالعملهای خاص خود را داشته باشد.

7. آیا میتوانم از robots.txt برای کنترل نحوه رتبهبندی صفحاتم در نتایج جستجو استفاده کنم؟

خیر، robots.txt نمیتواند برای کنترل نحوه رتبهبندی صفحات شما در نتایج جستجو استفاده شود. رتبهبندی صفحات در نتایج جستجو بر اساس عوامل مختلفی مانند کیفیت محتوا، لینکهای ورودی و معیارهای دیگر تعیین میشود.

سخن پایانی درباره robots.txt

robots.txt یک ابزار قدرتمند است که میتواند برای کنترل نحوه فهرستبندی وبسایت شما توسط موتورهای جستجو استفاده شود. با استفاده صحیح از robots.txt، میتوانید اطمینان حاصل کنید که وبسایت شما بهینه شده است و برای کاربران و موتورهای جستجو مناسب است.

گردآوری:بخش کامپیوتر و اینترنت بیتوته